谙流 ASP × 浦发银行: 万亿级消息处理平台

公司简介

上海浦东发展银行股份有限公司(简称浦发银行)是中国领先的全国性股份制商业银行。浦发银行已构建起国际化、综合化的经营服务格局。集团化发展稳步推进,已覆盖信托、基金、理财、金租赁、境外投行、村镇银行、货币经纪等多个业态。其中云平台作为支撑全行核心业务的数字化基础设施,承载着实时交易清算、跨系统数据同步、风控反欺诈决策等多个核心场景。

挑战与痛点

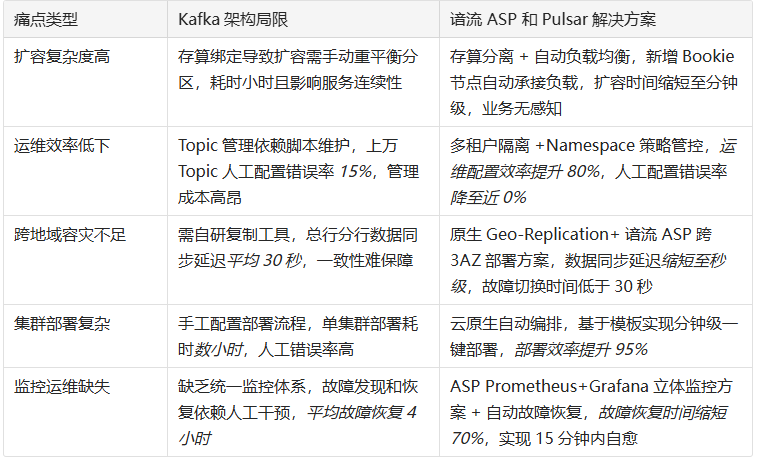

作为支撑浦发银行核心业务的数字化平台,浦发云平台需要处理包括实时交易清算、跨系统数据同步、风控反欺诈决策、全链路日志分析等关键场景。这些业务对消息中间件提出了严苛要求:在跨业务系统的数据同步场景中,必须保障分布式事务一致性;在反欺诈场景需实现毫秒级加密消息处理;面对总行与分行的业务协同,则要求跨地域数据同步能力。此前采用的 Kafka 架构面临显著的挑战:

1. 扩容复杂度高,服务连续性受影响

存储层扩容需手动重平衡分区,耗时长达数小时且影响服务连续性。在业务高峰期,这种长时间的扩容过程严重影响关键金融业务的正常运行。

2. 运维效率低下,管理成本高昂

Topic管理依赖脚本维护,在海量Topic规模下运维效率低下。单个集群管理超过上万个Topic时,人工配置错误率居高不下。

3. 多 AZ 和跨地域容灾能力不足

跨地域容灾需自研复制工具,数据一致性难以保障。总行与分行之间的数据同步延迟过高,无法满足实时风控决策的要求,而且稳定性问题难以解决。

谙流科技如何帮助浦发银行补强同城多 AZ 和异地多活的容灾架构,从而支撑起万亿级消息处理平台。

解决方案:开源 Pulsar 消息基座+ASP 容灾补强,驱动金融数字化转型

经过对主流消息组件的深度测试,浦发云平台技术团队最终选定Apache Pulsar作为新一代消息基座,同时联合谙流科技,针对性补强了同城多 AZ 和异地多活的容灾架构:

存算分离+原生 GEO 复制,突破扩容瓶颈,实现从"数小时级"到"分钟级"跃升

依托于 Pulsar 通过无状态计算节点(Broker)和分布式存储层(Bookie)的存算分离架构,将消息处理与持久化存储解耦,配合浦发银行自研的云原生+分布式协同架构设计,在谙流科技补强金融级高可用的前提下,实现运维效率质的飞跃。

改造后:

- 扩容能力实现质的跃升:存储层扩容从原Kafka需停机重平衡小时级缩短至分钟级,新增Bookie节点自动负载承接,整个过程业务无感知,彻底解决了业务高峰期长时间扩容影响关键金融业务的问题。

- 运维管理效率显著提升:通过租户(Tenant)机制实现软隔离,配合Namespace分组管理,Topic管理从依赖脚本维护转为自动化策略管控,运维人员配置效率提升80%,管理上万Topic时人工配置错误率从15%降至近0%。

- 跨地域容灾能力全面增强:依托于谙流 ASP Geo-Replication 方案实现异步跨域复制,替代原有Kafka+Redis+自研同步工具的复杂架构,总行与分行数据同步延迟从平均30秒缩短至秒级,单AZ中断时服务切换时间低于30秒,满足实时风控决策要求。

多租户隔离+精准流控,突破管理复杂度瓶颈,实现"脚本化"到"策略化"跃升

通过Pulsar独有的租户隔离机制与Namespace策略管控体系,配合谙流 ASP Bookie亲和性策略方案实现硬隔离,将传统依赖人工脚本的Topic管理模式升级为策略化自动管控。

改造后:

- 多业务线安全共存:支持支付、风控、日志等业务线在共享集群中安全共存,通过租户配额与Namespace策略实现资源隔离,避免不同业务间相互影响和资源占用,保障关键业务IO资源。

- 流控保障精准到位:通过租户级消息发布/消费速率限制,防止突发流量冲击核心系统,确保支付交易链路稳定,业务峰值冲击时系统稳定性提升90%。

- 自动化管控全面覆盖:200+集群的自动化管控能力,租户创建自动关联存储配额与权限,谙流 ASP GEO复制策略通过命名空间级配置实现,大大提升集群管理和运维效率。

云原生+分布式协同,突破部署复杂度瓶颈,实现从"手工化"到"自动化"跃升

基于谙流 ASP云原生方案,构建跨3AZ资源编排体系,配合Pulsar原生能力实现云原生分布式消息服务。

改造后:

- 部署效率跨越式提升:基于ASP方案定义3AZ资源编排规范,Kubernetes自动批量创建/管理跨AZ Pulsar服务资源,实现分钟级一键部署,部署效率提升95%。

- 监控体系立体化覆盖:构建Prometheus+Grafana+Elasticsearch三位一体监控体系,实时采集broker_messagesIn(消息流入速率)、bookie_writeLatency(写入延迟)等关键指标,可视化跨3AZ服务状态与GEO复制实时运行情况。

- 故障恢复能力显著增强:1000+节点分布式架构验证跨AZ故障自动恢复能力,检测异常时触发云盘迁移与K8s节点重调度,平均故障恢复时间缩短70%,实现故障快速发现与恢复。

成果与量化影响

1. 平台规模化运行能力显著提升

当前200+生产集群稳定承载日均万亿级消息吞吐,覆盖交易清算、实时风控、日志汇聚等全业务场景。1000+节点的分布式架构已验证跨AZ故障自动恢复能力,单AZ中断时服务切换时间低于30秒,满足金融业务高可用要求。

2. 运维效率大幅改善

- 部署效率提升:集群部署时间从小时级缩短至分钟级,显著提升效率。

- 扩容能力增强:存储层扩容无需数据重平衡,新增节点自动承接负载,实现业务无感知扩容。

- 管理复杂度降低:通过租户隔离+Namespace分组管理,运维人效比显著提升。

3. 业务场景全面覆盖

- 多租户隔离:支持支付、风控、日志等业务线在共享集群中安全共存,通过租户配额与Namespace策略实现资源隔离

- 跨地域协同:基于原生Geo-Replication能力,为总行-分行跨区业务提供异步数据同步通道

- 流控保障:通过租户级消息发布/消费速率限制,防止突发流量冲击核心系统,确保支付交易链路稳定

核心技术优势:

- 存算分离架构:无状态Broker+有状态Bookie设计,实现计算存储解耦

- 多租户隔离:租户级资源配额与权限控制,支持200+集群自动化管控

- 原生GEO复制:跨地域异步数据同步,替代复杂自研工具链

- 云原生部署:Kubernetes云原生部署实现跨3AZ资源编排和自动化部署

- 智能监控:三位一体监控体系,实时采集关键性能指标并自动故障恢复

通过以上技术特性的全面应用,全面解决了浦发银行面临的扩容复杂度高、运维效率低下、多AZ和跨地域容灾能力不足三大核心痛点,成功构建了承载日均万亿级消息吞吐的金融级消息基座,为金融级消息中间件服务提供了可靠的技术保障。

推荐阅读

谙流 ASK × 深南电路:PCB 生产全链路数据秒级传输

深南电路作为国内印制电路板行业龙头企业,需传输、处理来自多个生产基地的智能制造数据,包括生产线设备监控信息、工艺参数数据、质量检测数据及供应链协同信息等,单日数据量超过500TB。

谙流 ASP × 华泰证券:跨地域、多容灾的消息中间件 PaaS 平台助力订阅中心交易性能 15 倍跃升

华泰证券基于 ASP 构建的消息中间件SaaS 平台,很好的解决了当前的技术痛点,同时更为其未来业务扩展、合规升级、技术创新奠定了坚实的基础设施底座,为证券行业消息中间件平台化建设提供了完整的实践参考指南。

谙流 ASK × 中国联通:2.25 小时→秒级,存算分离革新数据传输

中国联通联合谙流科技部署谙流 ASK 商业化解决方案,核心依托存储与计算分离架构实现突破,彻底解决传统 Kafka 架构的固有局限。

端到端加密,多团队数据安全共享

谙流科技由 Apache Pulsar 和 Apache BookKeeper 的核心人员倾力打造,专注提供云原生消息队列(MQ)和流处理(Streaming)基础软件及解决方案,打造统一消息流 PaaS 平台,助力企业数字化新质生产力。

关注谙流,获取最新动态